Durante los tres días de la XIII edición de la Conferencia, se analizaron, desde una perspectiva legal, regulatoria, académica y tecnológica, los retos de la Protección de Datos y del desarrollo de la Inteligencia Artificial, así como sus posibles impactos en la sociedad actual bajo el título “Protección de Datos e Inteligencia Artificial”.

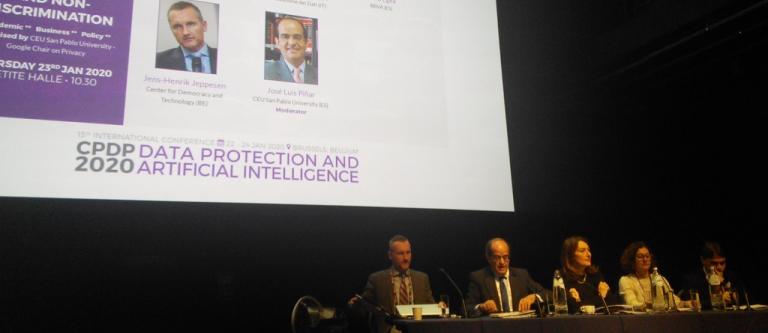

Para esta edición, la Cátedra organizó el panel “Transparencia algorítmica y no discriminación”, centrado en el impacto potencial del uso de algoritmos sobre los derechos fundamentales y las libertades públicas de los ciudadanos. Además, se hizo hincapié en el uso de los datos en base a mecanismos que aseguren su transparencia para evitar prácticas abusivas y discriminatorias.

Durante el Panel, José Luis Piñar, Titular de la Cátedra Google y único representante de España en el Comité Científico del CPDP, puso el acento en la necesaria colaboración y trabajo entre expertos de diferentes sectores para afrontar la cuestión del uso de los algoritmos y evitar que de ello deriven prácticas discriminatorias: “para que la transparencia de los algoritmos pueda ayudar a limitar el impacto en la protección de datos personales en el contexto de la Inteligencia Artificial, es esencial que equipos multidisciplinares colaboren estrechamente”, afirmó.

Durante su intervención, Bojana Bellamy, Presidenta del Hunton Andrews Kurth LLP’s Centre for Information Policy Leadership, puso de manifiesto “la relación entre la Inteligencia Artificial y los principios tradicionales de la Protección de Datos”. En este sentido, resaltó que el Reglamento General de Protección de Datos “se puede aprovechar para garantizar el desarrollo y la implementación responsable de la Inteligencia Artificial en base a los principios de transparencia, equidad y no discriminación”.

Por su parte, el Presidente del Istituto Italiano per la Privacy e la Valorizzazione dei Dati Luca Bolognini explicó las diferencias entre el uso de algoritmos para fines públicos o privados. Sobre la esfera pública, matizó que “los algoritmos deben ser totalmente verificables por las autoridades competentes, judiciales y/o independientes”. En cuanto a su uso para fines privados, opinó que “deben ser utilizados con transparencia, siempre equilibrada con otros derechos y libertades con el objetivo de proteger las inversiones y la innovación”.

Además, propuso mirar más allá del RGDP, más en concreto más allá del artículo 22, con el fin de introducir el novedoso principio del “Estado de derecho humano” en las Constituciones nacionales o en la Carta de Derechos Fundamentales de la UE.

“Este principio debería ser de aplicación incluso para el caso de decisiones automatizadas y basadas en el uso de datos no-personales, con la posibilidad – para cada persona – de requerir la intervención humana en la toma de decisiones, garantizando finalmente que los super-admin y los legisladores siempre y exclusivamente sean seres humanos”, opinó.

Flora Egea, DPO del Grupo BBVA, afirmó que el marco europeo encargado de regular la imparcialidad, que debe estar presente en todo algoritmo, tiene "una aplicación complicada porque varía dependiendo del sector”. Para Egea, las entidades deben velar por un resultado no discriminatorio en sus algoritmos; y en este sentido, subrayó que “el RGPD no permite a la entidad recabar y tratar los datos de vulnerabilidad a causa del principio de minimización y de proporcionalidad”. En cuanto a la transparencia, consideró necesario que se “aclare que es ‘suficiente’ para cumplir con la exigencia de “explicabilidad” de un algoritmo porque entenderlo como información al detalle no es un planteamiento realista, ni protege mejor los derechos fundamenta les”. Finalmente matizó que “pondría en peligro la innovación algorítmica”

Por último, Jens-Henrik Jeppesen presentó el ‘Digital Decisions Tool’ desarrollado por el Center for Democracy and Technology, una herramienta para la utilización de algoritmos para la toma de decisiones, según explicó. Tal como indicó Jeppesen, esta utilidad se basa en un modelo “que establece cómo los diseñadores de herramientas algorítmicas para la toma de decisiones pueden garantizar que el producto o el servicio no genere ni sesgos ni discriminación de manera injustificada”.